Wygrzewanie kabli jest jednym z tematów, które budzą kontrowersje. Najciekawsze jest to, że osoby optujące za tym, że wygrzewanie ma wpływ na kabel nie rozumieją czym jest prąd elektryczny.

W potocznym rozumieniu prąd elektryczny polega na tym, że elektrony wędrują wzdłuż przewodnika z prędkością światła lub do niej zbliżoną. I wobec tego po jakimś czasie te elektrony spowodują, że drogi, którymi się one poruszają będą "lepsze" na zasadzie takiej jak wydeptana ścieżka czy noszone przez jakiś czas buty.

Prąd elektryczny jeśli się to odniesie do prądu przemiennego praktycznie nie polega na ruchu elektronów. Elektrony poruszają się i można obliczyć z jaką prędkością, a ta prędkość nazywana jest dryftem.

Średnia prędkość dryftu elektronów w przewodniku wynosi około 10−4 m/s = 0,1 mm/s. W odniesieniu do prądu przemiennego elektrony poruszają się przez pewien czas wynikający z częstotliwości w jedną i następnie w przeciwną stronę. Wobec tego elektrony w sumie nie ruszają się z miejsca, ponieważ poruszają się na odległość ułamka mikrometra ze wspomnianą prędkością 0,1mm/s w jedną stronę przewodnika, a następnie w przeciwną czyli oscylują wokół określonego miejsca.

Wyobrażenie sobie, że elektrony przy częstotliwości 20 kHz przemierzą kabel głośnikowy o długości np. 2 metry 20.000 razy na sekundę w każdą stronę jest błędne. Dystans, który przemierzy elektron w ciągu sekundy nie wyniesie 40 kilometrów, a jedynie około 0,1mm.

Innym aspektem tzw. wygrzewania kabli byłoby, że zmieniają one pod wpływem prądu swe właściwości. W związku z tym przewodnik musiałby wykazać inne właściwości fizykochemiczne gdyby został "wygrzany". Jednak nikt nigdy nie stosował technologii zmiany właściwości metalu przez przepuszczanie przez niego symfonii.

Ale może to jest sposób na zamianę miedzi w złoto?

sobota, 27 sierpnia 2016

wtorek, 23 sierpnia 2016

Holografia, dźwięk 3D, przestrzenność

Efektu przestrzenności nie można uzyskać z dwu głośników. Jednak czasem ktoś pisze, że słyszy dźwięki dochodzące z góry, z dołu, z przed głośników i zza nich, a ponadto spoza bazy stereo tzn. na prawo od prawej kolumny i vice versa.

Dźwięk słychać z tego miejsca, gdzie jest jego źródło. Jeśli w danym miejscu nie ma źródła dźwięku i ktoś uważa, że tam miejscu coś słyszy to znaczy, że mu się zdaje.

W stereo dźwięk powinien być słyszalny z każdego miejsca pomiędzy głośnikami. Czy tak jest faktycznie? Zagadnienie jest bardziej skomplikowane, niż by się mogło wydawać. Po co jest głośnik centralny w systemach dźwięku przestrzennego? Skoro prawdą byłoby, że baza stereo faktycznie jest pomiędzy głośnikami, to głośnik centralny byłby bez sensu. Warto przypomnieć sobie, że identyczne źródła dźwięku powodują, że dokładnie w połowie odległości pomiędzy nimi powstaje cisza.

Umieszczenie pozornego źródła dźwięku w bazie stereo sprawia pewne trudności. Cóż dopiero, gdy dźwięk ma być słyszalny z miejsc, które są poza bazą? Jak już zostało powiedziane dźwięk słychać z miejsca, gdzie jest jego źródło. Realizatorzy potrafią jednak "zamarkować" miejsce wydobywania się dźwięku poza bazą stereo.

Słuch koduje informacje przestrzenne przy pomocy małżowin. Ich specyficzny kształt powoduje, że dźwięki napływające z różnych kierunków są w pewien sposób filtrowane. Jeśli realizator nada dźwiękowi barwę taką, która powstaje przy dochodzeniu z określonego kierunku można uzyskać złudzenie, że źródło dźwięku jest np. powyżej głośników lub z tyłu. Jednak nie zawsze się to sprawdza, bo każdy ma uszy o innym kształcie i efekt będzie działać tylko na wybrane osoby. Tak czy inaczej kształtowanie barwy dźwięku w celu imitowania kodowania przestrzennego daje raczej marne efekty. Najlepiej sprawdza się, jeśli opis płyty "podpowiada" z jakiego kierunku słuchacz powinien dźwięki słyszeć. Jeszcze lepiej, jeśli są rysunki.

Poszerzenie bazy stereo jest tak stare, jak radiomagnetofony. Dodanie części sygnału z przeciwnego kanału i w przeciwfazie pozwala sztucznie rozszerzyć bazę poza głośniki. Jednak jeśli się przesadzi to dźwięk wydaje się być "wywrócony na lewą stronę" i nienaturalny.

Efekt "przestrzenności" uzyskuje się przez dodanie opóźnień, ale największy udział w tym ma sam pokój, w którym się słucha. Odbicia, które docierają do słuchacza z opóźnieniem powodują, że dźwięk nabiera powietrza i trójwymiarowości. Efekt najlepiej jest słyszalny w akustyce łazienki, tzn. w silnych odbiciach. Im lepsza akustyka czyli odbicia są słabsze, tym efekt przestrzenności zanika. W optymalnych warunkach czyli w strefie wolnej od odbić dźwięk jest słyszalny tylko z głośników i w zakresie bazy stereo, a żadnego wrażenia trójwymiarowości nie ma. Jeśli realizator zastosuje któryś z omówionych tricków służących do wywołania wrażenia dobiegania dźwięku z jakiegoś nietypowego kierunku, to też jest on raczej mało przekonujący, z tym wyjątkiem kiedy słuchacz ma akurat odpowiedni kształt ucha.

Jeśli słucha się w pomieszczeniu z silnymi odbiciami efekt przestrzenności polega na tym, że dźwięk słychać głównie z głośników, ale poza tym z każdego kierunki, bo odbija się wszędzie o wszystko. Silne odbicia są czymś na granicy, której słuch nie potrafi rozróżnić, czy to odbicie, czy już echo. Skoro ani to ani tamto, więc słuch decyduje, że dźwięk pochodzi z każdego kierunku, więc jest "przestrzenny". Dźwięk bezpośredni kotwiczy kierunek, tylko odbicia są kodowane jako dochodzące zewsząd.

Wszystkie opisy dotyczące holograficznego dźwięku itp. są skutkiem złej akustyki. Chociaż czasem nawet zawodowi akustycy zajmujący się adaptacją pomieszczeń pozostawiają trochę odbić poprzecznych, żeby dźwięk uzyskał nieco "przestrzeni".

Dźwięk słychać z tego miejsca, gdzie jest jego źródło. Jeśli w danym miejscu nie ma źródła dźwięku i ktoś uważa, że tam miejscu coś słyszy to znaczy, że mu się zdaje.

W stereo dźwięk powinien być słyszalny z każdego miejsca pomiędzy głośnikami. Czy tak jest faktycznie? Zagadnienie jest bardziej skomplikowane, niż by się mogło wydawać. Po co jest głośnik centralny w systemach dźwięku przestrzennego? Skoro prawdą byłoby, że baza stereo faktycznie jest pomiędzy głośnikami, to głośnik centralny byłby bez sensu. Warto przypomnieć sobie, że identyczne źródła dźwięku powodują, że dokładnie w połowie odległości pomiędzy nimi powstaje cisza.

Umieszczenie pozornego źródła dźwięku w bazie stereo sprawia pewne trudności. Cóż dopiero, gdy dźwięk ma być słyszalny z miejsc, które są poza bazą? Jak już zostało powiedziane dźwięk słychać z miejsca, gdzie jest jego źródło. Realizatorzy potrafią jednak "zamarkować" miejsce wydobywania się dźwięku poza bazą stereo.

Słuch koduje informacje przestrzenne przy pomocy małżowin. Ich specyficzny kształt powoduje, że dźwięki napływające z różnych kierunków są w pewien sposób filtrowane. Jeśli realizator nada dźwiękowi barwę taką, która powstaje przy dochodzeniu z określonego kierunku można uzyskać złudzenie, że źródło dźwięku jest np. powyżej głośników lub z tyłu. Jednak nie zawsze się to sprawdza, bo każdy ma uszy o innym kształcie i efekt będzie działać tylko na wybrane osoby. Tak czy inaczej kształtowanie barwy dźwięku w celu imitowania kodowania przestrzennego daje raczej marne efekty. Najlepiej sprawdza się, jeśli opis płyty "podpowiada" z jakiego kierunku słuchacz powinien dźwięki słyszeć. Jeszcze lepiej, jeśli są rysunki.

Poszerzenie bazy stereo jest tak stare, jak radiomagnetofony. Dodanie części sygnału z przeciwnego kanału i w przeciwfazie pozwala sztucznie rozszerzyć bazę poza głośniki. Jednak jeśli się przesadzi to dźwięk wydaje się być "wywrócony na lewą stronę" i nienaturalny.

Efekt "przestrzenności" uzyskuje się przez dodanie opóźnień, ale największy udział w tym ma sam pokój, w którym się słucha. Odbicia, które docierają do słuchacza z opóźnieniem powodują, że dźwięk nabiera powietrza i trójwymiarowości. Efekt najlepiej jest słyszalny w akustyce łazienki, tzn. w silnych odbiciach. Im lepsza akustyka czyli odbicia są słabsze, tym efekt przestrzenności zanika. W optymalnych warunkach czyli w strefie wolnej od odbić dźwięk jest słyszalny tylko z głośników i w zakresie bazy stereo, a żadnego wrażenia trójwymiarowości nie ma. Jeśli realizator zastosuje któryś z omówionych tricków służących do wywołania wrażenia dobiegania dźwięku z jakiegoś nietypowego kierunku, to też jest on raczej mało przekonujący, z tym wyjątkiem kiedy słuchacz ma akurat odpowiedni kształt ucha.

Jeśli słucha się w pomieszczeniu z silnymi odbiciami efekt przestrzenności polega na tym, że dźwięk słychać głównie z głośników, ale poza tym z każdego kierunki, bo odbija się wszędzie o wszystko. Silne odbicia są czymś na granicy, której słuch nie potrafi rozróżnić, czy to odbicie, czy już echo. Skoro ani to ani tamto, więc słuch decyduje, że dźwięk pochodzi z każdego kierunku, więc jest "przestrzenny". Dźwięk bezpośredni kotwiczy kierunek, tylko odbicia są kodowane jako dochodzące zewsząd.

Wszystkie opisy dotyczące holograficznego dźwięku itp. są skutkiem złej akustyki. Chociaż czasem nawet zawodowi akustycy zajmujący się adaptacją pomieszczeń pozostawiają trochę odbić poprzecznych, żeby dźwięk uzyskał nieco "przestrzeni".

wtorek, 16 sierpnia 2016

Jak dobrać moc wzmacniacza i kolumn c.d.

Dopasowanie kolumn do wzmacniacza nie jest ostatnio popularnym tematem. Na wstępie warto wspomnieć, że głośniki nie mają faktycznie żadnej mocy, mogą jedynie określoną moc przyjąć. W kwestii doboru wzmacniacza i kolumn istnieją dwie sprzeczne szkoły.

Szkoła starsza podaje, że moc wzmacniacza powinna być połową "mocy" kolumn. Ma to swoje uzasadnienie. Jeśli się mocno przesteruje wzmacniacz, to będzie on oddawał moc, gdy zasilacz jest wystarczająco wydajny, dwukrotnie większą od znamionowej. Mając więc wzmacniacz 2x100 można go przesterować do momentu, aż będzie oddawał 2x200W. Sygnał wyjściowy będzie przypominał przebieg prostokątny i zawierał nieparzyste harmoniczne. Poziom zniekształceń wzrośnie do około 40%.

W praktyce spektrum zakłóceń nie ma znaczenia i harmoniczne same w sobie nie stanowią jakiegoś szczególnego zagrożenia dla głośników. Energia coraz wyższych harmonicznych szybko spada. Ważna jest ogólna moc sygnału. Przesterowując wzmacniacz 2x100 do mocy 2x200W jest duża szansa na uszkodzenie kolumn mogących przetwarzać np. 130W. Jednak możliwość uszkodzenia kolumn przesterowanym słabszym wzmacniaczem jest znacznie mniejsza niż wtedy, kiedy będzie używany wzmacniacz dużo silniejszy niż kolumny.

Jeśli do dyspozycji są kolumny o mocy szczytowej 130W i wzmacniacz 200W na kanał przy głośniejszym słuchaniu bardzo łatwo jest przesadzić z mocą i spalić głośniki. O ile słaby wzmacniacz przy przesterowaniu zniekształca dźwięk, to silny dostarczy bez żadnych zniekształceń moc większą niż są w stanie znieść głośniki. W podanym przykładzie można mieć czysty sygnał o mocy 200W a więc 70W więcej niż mogą przyjąć głośniki. I dlatego, żeby spalić głośniki słabym wzmacniaczem trzeba wyjątkowego uporu, gdyż słysząc zniekształcony dźwięk odruchowo zmniejsza się głośność. Natomiast słuchanie głośno kiedy dźwięk brzmi dość czysto często zachęca do jej zwiększenia, co zazwyczaj nie kończy się dla głośników dobrze.

Dlatego nowsza szkoła twierdząca, że wzmacniacz powinien mieć moc większą niż głośniki bazuje raczej na tym, że te ostatnie będą mieć skuteczne zabezpieczenia chroniące przed przeciążeniem.

Na koniec warto wspomnieć, że moce rzędu 15-20W są wystarczające, żeby przy długotrwałym słuchaniu stracić stopniowo słuch.

Szkoła starsza podaje, że moc wzmacniacza powinna być połową "mocy" kolumn. Ma to swoje uzasadnienie. Jeśli się mocno przesteruje wzmacniacz, to będzie on oddawał moc, gdy zasilacz jest wystarczająco wydajny, dwukrotnie większą od znamionowej. Mając więc wzmacniacz 2x100 można go przesterować do momentu, aż będzie oddawał 2x200W. Sygnał wyjściowy będzie przypominał przebieg prostokątny i zawierał nieparzyste harmoniczne. Poziom zniekształceń wzrośnie do około 40%.

W praktyce spektrum zakłóceń nie ma znaczenia i harmoniczne same w sobie nie stanowią jakiegoś szczególnego zagrożenia dla głośników. Energia coraz wyższych harmonicznych szybko spada. Ważna jest ogólna moc sygnału. Przesterowując wzmacniacz 2x100 do mocy 2x200W jest duża szansa na uszkodzenie kolumn mogących przetwarzać np. 130W. Jednak możliwość uszkodzenia kolumn przesterowanym słabszym wzmacniaczem jest znacznie mniejsza niż wtedy, kiedy będzie używany wzmacniacz dużo silniejszy niż kolumny.

Jeśli do dyspozycji są kolumny o mocy szczytowej 130W i wzmacniacz 200W na kanał przy głośniejszym słuchaniu bardzo łatwo jest przesadzić z mocą i spalić głośniki. O ile słaby wzmacniacz przy przesterowaniu zniekształca dźwięk, to silny dostarczy bez żadnych zniekształceń moc większą niż są w stanie znieść głośniki. W podanym przykładzie można mieć czysty sygnał o mocy 200W a więc 70W więcej niż mogą przyjąć głośniki. I dlatego, żeby spalić głośniki słabym wzmacniaczem trzeba wyjątkowego uporu, gdyż słysząc zniekształcony dźwięk odruchowo zmniejsza się głośność. Natomiast słuchanie głośno kiedy dźwięk brzmi dość czysto często zachęca do jej zwiększenia, co zazwyczaj nie kończy się dla głośników dobrze.

Dlatego nowsza szkoła twierdząca, że wzmacniacz powinien mieć moc większą niż głośniki bazuje raczej na tym, że te ostatnie będą mieć skuteczne zabezpieczenia chroniące przed przeciążeniem.

Na koniec warto wspomnieć, że moce rzędu 15-20W są wystarczające, żeby przy długotrwałym słuchaniu stracić stopniowo słuch.

poniedziałek, 18 lipca 2016

Problem z pozostaniem na Ziemi czyli jitter 20 pikosekund

Czy ktoś czytał kiedyś deklaracje jakiegoś audiofila, że słyszy jitter 2 pikosekund? A może artykuł o tym, że można usłyszeć jitter 20 pikosekund? Jeśli nie, to nie ma problemu. Problem mają autorzy. Pierwszy ma zbyt wybujałą wyobraźnię, a drugi źle zinterpretował wyniki obliczeń.

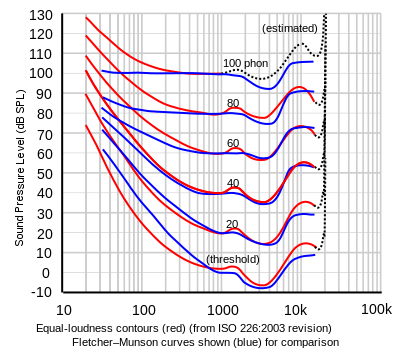

Jak można dojść do tak absurdalnego wniosku, że jitter 20 pikosekund jest słyszalny? W ten sposób, że nakładając poziom zakłóceń na krzywą Fletchera-Munsella trafia on dokładnie na sam dół krzywej poziomu słyszalności. Czyli zakłócenie ma poziom prawie -10 dB. Warto pamiętać, że 0 dB SPL nie znaczy, że zmiany w ciśnieniu wynoszą zero, więc stąd biorą się ujemne db. Faktycznie taki poziom dźwięku można usłyszeć w komorze bezechowej, gdzie panuje absolutna cisza. Pytanie jest jednak następujące: poziom zakłóceń to około -10 dB, a co z sygnałem?

Zniekształcenia nie istnieją w oderwaniu od przetwarzanego sygnału. Jeśli są zniekształcenia, to jest też sygnał, który został zniekształcony. Dlatego takie teoretyzowanie, że jeśli człowiek - chyba bardzo młody i zdrowy, dodajmy - słyszy poniżej zera dB, tzn. słyszy ujemne decybele, to nie znaczy, że usłyszy taki poziom zakłóceń. Nie usłyszy, bo fundamentalna będzie stokilkadziesiąt dB głośniejsza.

Żeby rzecz była jasna. Ktoś umyślił sobie, że skoro zakłócenia są na poziomie jeszcze słyszalnym, to po usunięciu sygnału je się da usłyszeć. Ale problem w tym, że musi grać muzyka, żeby były zakłócenia. Nie ma opcji wyciszenia muzyki, czyli zlikwidowanie sygnału, po to, żeby słuchać samych zakłóceń.

Można usłyszeć odgłos przeskakującej iskry w świecy zapłonowej, ale na to trzeba ją wykręcić z silnika. Natomiast nie da się tego usłyszeć, jak silnik pracuje.

To jest właśnie problem teoretyków. Tak jak nie ma sensu mówić o odgłosach świecy bez pracy silnika, tak nie ma sensu mówić o zakłóceniach bez sygnału czy muzyki.

W dobrej jakości przetworniku jitter rzędu 200 ps jest bardzo dobrą wartością i z całą pewnością jest niemożliwy do usłyszenia.

Jak można dojść do tak absurdalnego wniosku, że jitter 20 pikosekund jest słyszalny? W ten sposób, że nakładając poziom zakłóceń na krzywą Fletchera-Munsella trafia on dokładnie na sam dół krzywej poziomu słyszalności. Czyli zakłócenie ma poziom prawie -10 dB. Warto pamiętać, że 0 dB SPL nie znaczy, że zmiany w ciśnieniu wynoszą zero, więc stąd biorą się ujemne db. Faktycznie taki poziom dźwięku można usłyszeć w komorze bezechowej, gdzie panuje absolutna cisza. Pytanie jest jednak następujące: poziom zakłóceń to około -10 dB, a co z sygnałem?

Zniekształcenia nie istnieją w oderwaniu od przetwarzanego sygnału. Jeśli są zniekształcenia, to jest też sygnał, który został zniekształcony. Dlatego takie teoretyzowanie, że jeśli człowiek - chyba bardzo młody i zdrowy, dodajmy - słyszy poniżej zera dB, tzn. słyszy ujemne decybele, to nie znaczy, że usłyszy taki poziom zakłóceń. Nie usłyszy, bo fundamentalna będzie stokilkadziesiąt dB głośniejsza.

Żeby rzecz była jasna. Ktoś umyślił sobie, że skoro zakłócenia są na poziomie jeszcze słyszalnym, to po usunięciu sygnału je się da usłyszeć. Ale problem w tym, że musi grać muzyka, żeby były zakłócenia. Nie ma opcji wyciszenia muzyki, czyli zlikwidowanie sygnału, po to, żeby słuchać samych zakłóceń.

Można usłyszeć odgłos przeskakującej iskry w świecy zapłonowej, ale na to trzeba ją wykręcić z silnika. Natomiast nie da się tego usłyszeć, jak silnik pracuje.

To jest właśnie problem teoretyków. Tak jak nie ma sensu mówić o odgłosach świecy bez pracy silnika, tak nie ma sensu mówić o zakłóceniach bez sygnału czy muzyki.

W dobrej jakości przetworniku jitter rzędu 200 ps jest bardzo dobrą wartością i z całą pewnością jest niemożliwy do usłyszenia.

sobota, 4 czerwca 2016

Słuchawki - dlaczego nie? I dlaczego nie.

Dobry odbiór muzyki w niezaadaptowanym pomieszczeniu nie jest możliwy. Rozwiązaniem problemów z transmisją dźwięku mogłoby być użycie słuchawek, jednak taki odsłuch jest często niesatysfakcjonujący i wybiera się głośniki w pomieszczeniu złym akustycznie.

Często odsłuch głośnikowy odbywa się w strefie dalekiej, gdzie przeważają odbicia, wobec tego słuchawki eliminujące je do zera powinny brzmieć bezkonkurencyjnie. Wiadomo jednak, że słuchawki nie zawsze dobrze grają.

Wiele typów słuchawek jest źle zrównoważonych tonalnie i zazwyczaj mają za bardzo uwypuklone basy.

Warto poświęcić trochę wysiłku i znaleźć słuchawki o wyrównanej charakterystyce, ale w przystępnej cenie. Przy czym opisy brzmienia są nieprzydatne, trzeba mieć dostęp do pomiarów. Im charakterystyka bardziej płaska, tym lepiej.

Trzeba jednak zwrócić uwagę na sposób wykonania pomiarów. Zwyczajne pomierzenie charakterystyki nie da potrzebnych informacji, bo przetwornik jest przy samym uchu. Dlatego przydatne są te pomiary, gdzie wyraźnie zaznaczono, że są skompensowane. Jeśli pomiary są niekompensowane, trzeba mieć odpowiednią wiedzę i doświadczenie, żeby je zinterpretować.

Jest jeszcze jeden problem ze słuchawkami. Dużo nagrań nie nadaje się do takiego słuchania, po prostu realizator wykonał je w pomieszczeniu nie-neutralnym. W jego studio nagrania brzmiały dobrze, obiektywnie takie nie są. Zazwyczaj brakuje im przestrzenności. W reżyserce przestrzenność była, bo miała słabą adaptację, albo niedostateczną. Naprawdę dobre realizacje w słuchawkach brzmią bardzo przyjemnie.

Pozostaje jeszcze przyzwyczajenie do obecności silnych odbić pomieszczenia. Jeśli się jednak często słucha przez dobre słuchawki, można taki odbiór muzyki docenić. Obiektywnie jakość jest lepsza niż przez głośniki.

Często odsłuch głośnikowy odbywa się w strefie dalekiej, gdzie przeważają odbicia, wobec tego słuchawki eliminujące je do zera powinny brzmieć bezkonkurencyjnie. Wiadomo jednak, że słuchawki nie zawsze dobrze grają.

Wiele typów słuchawek jest źle zrównoważonych tonalnie i zazwyczaj mają za bardzo uwypuklone basy.

Warto poświęcić trochę wysiłku i znaleźć słuchawki o wyrównanej charakterystyce, ale w przystępnej cenie. Przy czym opisy brzmienia są nieprzydatne, trzeba mieć dostęp do pomiarów. Im charakterystyka bardziej płaska, tym lepiej.

Trzeba jednak zwrócić uwagę na sposób wykonania pomiarów. Zwyczajne pomierzenie charakterystyki nie da potrzebnych informacji, bo przetwornik jest przy samym uchu. Dlatego przydatne są te pomiary, gdzie wyraźnie zaznaczono, że są skompensowane. Jeśli pomiary są niekompensowane, trzeba mieć odpowiednią wiedzę i doświadczenie, żeby je zinterpretować.

Jest jeszcze jeden problem ze słuchawkami. Dużo nagrań nie nadaje się do takiego słuchania, po prostu realizator wykonał je w pomieszczeniu nie-neutralnym. W jego studio nagrania brzmiały dobrze, obiektywnie takie nie są. Zazwyczaj brakuje im przestrzenności. W reżyserce przestrzenność była, bo miała słabą adaptację, albo niedostateczną. Naprawdę dobre realizacje w słuchawkach brzmią bardzo przyjemnie.

Pozostaje jeszcze przyzwyczajenie do obecności silnych odbić pomieszczenia. Jeśli się jednak często słucha przez dobre słuchawki, można taki odbiór muzyki docenić. Obiektywnie jakość jest lepsza niż przez głośniki.

sobota, 21 maja 2016

Winyl

Prasa Hi-fi zajmuje się intensywnym lansowaniem płyt winylowych i sprzętu do ich odtwarzania. Promowanie zapisu mechanicznego jest absurdem, bo jest metodą ustępującą pod każdym względem nowszym technikom już nie tylko pod względem jakości, ale przede wszystkim komfortu i trwałości.

Płyta winylowa jest nośnikiem trwałym wtedy, gdy nie jest odtwarzana, każdorazowe jej zagranie powoduje degradację zapisu. Najszybciej można zorientować się w skali zjawiska, jeśli igła zostanie opuszczona na czyste miejsce. Okaże się, że igła zostawi na płycie wgniecenie. Zamiast płyt można użyć płytki CD albo DVD. Po opuszczeniu igły na płytę obracamy powoli talerz gramofonu. Każdy ruch pozostawia na płycie ślad. Jeśli się użyje do regulacji siły dośrodkowej czystej płyty lub płytki CD/DVD okaże się, że powierzchnia płyty jest mocno porysowana. Płyty winylowe stwarzają problemy jeśli trzeba ich użyć do wykonania pomiarów, np. wkładki. Zapis po każdym odtworzeniu ulega starciu i dlatego w pewnym momencie pomiary nie są już miarodajne.

Na płycie winylowej można z pewnymi ograniczeniami zapisać pełne pasmo, ale trudność sprawia odczyt.

Jedyną szansą na niezniekształcony odczyt wysokich częstotliwości dla fragmentu płyty w pobliżu jej środka jest gramofon laserowy. Średnica promienia lasera śledzącego zapis jest znacznie mniejsza niż rozmiary igły gramofonowej. Typowa igła nie zmieści się w najgęstsze składniki zapisu. Poniższy rysunek przedstawia wielkość realnej igły i teoretyczną wymaganą. Jednak w praktyce nie jest możliwe wykonanie szlifu z tak małymi krzywiznami.

Jakość dźwięku jest tym gorsza im bliżej środka. Producenci przeciwdziałają temu w ten sposób, że dla końcowych minut zapisu modyfikują go zmniejszając ilość najwyższych częstotliwości. Kształtowanie dźwięku, żeby uniknąć zniekształceń jest powodem ukucia terminu "ciepły dźwięk analogu". Nie ma możliwości nacięcia matrycy z normalną ilością wysokich tonów. Powody są dwa. Przede wszystkim głowica nacinająca nie jest w stanie naciąć większej ilości wysokich tonów bez zniekształceń. Po drugie większa, czyli zwyczajna nawet dla nagrań wykonanych analogowo, ilość wysokich tonów spowoduje przegrzanie się i być może nawet spalenie głowicy.

Zbyt duża dynamika zapisu spowoduje przeciążenie samej wkładki gramofonowej, która może nie być w stanie śledzić dużych amplitud. Z kolei, jak to widać na rysunkach, większa amplituda wysokich tonów w granicach możliwości głowicy nacinającej będzie niemożliwa do śledzenia przez bardziej proste szlify igły. Igła sferyczna nie ma szans, igła eliptyczna nie zawsze będzie w stanie zmieścić się w gęstym zapisie, jedynie najbardziej zaawansowane kształty igły mogłyby sprostać zadaniu, ale i tak nie udałoby się poprawnie odczytać płyty naciętej 1:1 z typowego pliku. Odczytać górę pasma bez zniekształceń można, ale tylko wtedy, kiedy amplituda nie przekroczy pewnej wielkości, czyli zawsze trzeba ściszyć wysokie tony.

Paradoksalnie lepsza jakość zapisu na płytach nacinanych systemem DMM skutkuje gorszą jakością odtwarzania, bo głośniejszy i zawierający bardziej normalną ilość wysokich tonów dźwięk jest nie do odtworzenia przez tańsze wkładki ze sferycznym szlifem igły.

Dlatego, że mało kto używa referencyjnych wkładek, producenci nacinają płyty bardziej zachowawczo niż to by było konieczne dla najlepszych systemów. Ale nawet bezkompromisowo nacięta płyta nie jest w stanie dorównać dynamiką i jakością zapisowi cyfrowemu. Poza tym problemem są matryce z lakierem. Źle nacięte powodują przesłuchy pomiędzy sąsiadującymi rowkami, spada dynamika, wzrastają zniekształcenia. Za gorące ostrze - lakier będzie się topił i płynął. Za zimne - lakier będzie się ciągnął jak guma. W obu przypadkach wzrosną zniekształcenia i spadnie dynamika. Dlatego nacięcie płyty jest sztuką. I z całą pewnością nikt w Polsce nigdy nie naciął acetatu prawidłowo. Najczęstsza wada polskich płyt to preecho kiedy słychać dźwięk przebity z sąsiedniego rowka. Właśnie dlatego często utwory zaczynają się "dwa razy". Raz bardzo cicho, a potem zwyczajnie. Trzeba jednak mieć świadomość tego, że ten przesłuch dotyczy całej płyty. Słychać go zazwyczaj na początku, ale występuje cały czas. Sprawdzić: "Zdzisław Piernik – Tuba" Polskie Nagrania.

Mało kto zadaje sobie pytanie jakiego poziomu zakłóceń można się spodziewać po samej płycie. Jeśli płyta jest wykonana ze szczególną starannością, zakłócenia będą wyglądać następująco:

Na wykresie spektrum zakłóceń od płyty (razem z zakłóceniami z gramofonu, ale te są bardzo małe) jest zaznaczone kolorem czerwonym. Po uśrednieniu okazuje się, że dla 20 Hz odstęp od zakłóceń jest tylko 65 dB, dla 100 Hz 80 dB i dopiero powyżej 200 Hz zakłócenia spadają do -90 dB. Ale nie znaczy to, że odstęp od szumu dla płyty winylowej wynosi 90 dB. Taki odstęp od zakłóceń jest od 200 do 500 Hz. Winyl szumi dosyć głośno i nie sposób tego nie usłyszeć. Zakłócenia w zakresie niskich częstotliwości na płytach z muzyką są większe niż na płytach testowych. Starsze płyty mają dość bogate spektrum przeróżnych całkiem głośnych zakłóceń. Ważony odstęp od zakłóceń dla dobrego gramofonu to zaledwie 70 dB.

Jakim poziomem zniekształceń jest obarczony zapis na samej płycie? Nacinanie płyty odbywa się na granicy wytrzymałości termicznej głowicy. Towarzyszą temu również problemy mechaniczne, które powodują powstanie zniekształceń. Każdy, kto słuchał kiedykolwiek płyt winylowych wie, że dźwięk nie jest zupełnie czysty.

Głowica nacinająca jest sterowana wzmacniaczem o mocy kilkuset wat. Można przyjąć dla uproszczenia, że wzmacniacz ma 2x1000W - dwa kilowaty. Nie dziwi więc, że przy takich mocach uzwojenie głowicy może się przegrzać i spalić.

Dlaczego trzeba użyć takich mocy? Dlatego, że głowica ma pewną masę i może być tłumiona wyłącznie mechanicznie. Głośniki niskotonowe są tłumione zarówno mechanicznie, przez zawieszenie górne i dolne, ale też elektrycznie. Tłumienie elektryczne wiąże się z osławionym współczynnikiem tłumienia. W przypadku głowicy nacinającej nie jest możliwe tłumienie elektryczne z wielu względów. Jednak właśnie dlatego, że jest możliwe tłumienie tylko mechaniczne, głowica musi być zawieszona bardzo twardo. Tak twarde zawieszenie jest konieczne, bo zniekształcenia w przeciwnym razie będą zbyt duże. I przede wszystkim stąd biorą się tak duże moce wzmacniaczy. Warto się nad tym przez chwilę zastanowić: dwa kilowaty, żeby wychylenie wyniosło mniej niż milimetr. Kilowat na część milimetra w jednym kanale i kilowat na część milimetra w drugim.

Jeśli chodzi o wydania zagraniczne trzeba wprawnego ucha, żeby wychwycić zniekształcenia, bo specjaliści nacinający matryce świetnie orientują się w ograniczeniach i możliwościach sprzętu, więc mogą tak wpłynąć na dźwięk, żeby nie dopuścić do przeforsowania głowicy. Jak się to robi, to dość obszerny temat, głównie wpływa się na barwę obniżając ilość wysokich tonów i spłaszcza impulsy. Jednak w Polsce osoby nacinające płyty raczej nie miały wystarczającej wiedzy i umiejętności, a być może także nie miały do dyspozycji odpowiednich narzędzi. W każdym razie prawie zawsze można usłyszeć zniekształcenia na polskich wydawnictwach. Dowodzi to, że zapis na płycie ma duże ograniczenia i jeśli się nie podejmie odpowiednich kroków, wyjdą one na jaw w pełnej krasie.

W latach siedemdziesiątych, posługiwano się często sprzętem do nacinania matryc, który miał zniekształcenia rzędu jeden-dwa procenty, ale taki poziom zniekształceń może się utrzymać najwyżej do połowy strony, dalej będzie już znacznie gorzej, a finał opery na końcu strony - szkoda słów. I te zniekształcenia są na tych płytach. Nie zawsze je słyszymy, ale one są, a są trudne do uchwycenia, bo nie mamy możliwości porównania jak brzmi master.

Zobaczmy teraz jak się sprawy mają w odniesieniu do sprzętu odtwarzającego.

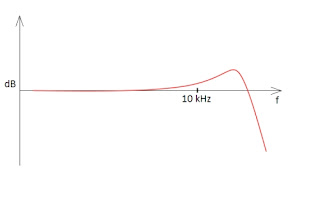

Jeśli chodzi o wkładki gramofonowe, to typowa charakterystyka częstotliwościowa wygląda w ten sposób:

Na schemacie jest widoczny garb w okolicach 20 kHz. Występuje on zawsze bez względu na typ wkładki i jest spowodowany rezonansem gumowego zawieszenia wspornika igły. Nie ma opcji, żeby tego uniknąć, a częstotliwość rezonansu zawiera się w przedziale 15-25 kHz. Parametr podawany dla wkładki czyli zniekształcenia wysokich tonów jest tak ważny, bo świadczy m.in. o tym jak dobrze udało się producentom uporać z rezonansem. Zazwyczaj wielkość zniekształceń wysokich tonów wynosi 0,1% jednak nie ma informacji dla jakich częstotliwości się je mierzy. Wydaje się, że pomiar następuje dla częstotliwości jeszcze nie dotkniętych rezonansem czyli około 10 kHz. Dla częstotliwości rezonansowych na pewno by się nie udało zejść ze zniekształceniami do tak niskiego poziomu.

Ale rezonans zawieszenia igły nie ma nic wspólnego z innym rezonansem.

Powyższy schemat pokazuje charakterystykę dla przedwzmacniacza MM. Podbicie wynika z nieodpowiednich parametrów przedwzmacniacza. Poniższy schemat jest w zasadzie obwodem rezonansowym. Od lewej: silnik wkładki, indukcyjność wkładki, opór wkładki, pojemność kabla, pojemność przedwzmacniacza i jego opór. Problem sprawiają zbyt duże C2 i R2

W skrajnych przypadkach podbicie wysokich tonów może sięgnąć nawet ponad 6 dB. Okazuje się jednak, że nie tylko wkładki MM nastręczają problemów. Również układy MC są podatne na zmiany parametrów obciążenia, przy czym głównie dotyczy to oporu. Jednak również pojemność może odgrywać pewną rolę, co widać na rysunku poniżej.

Dla wkładek MC ważniejszy jest opór i jego wpływ na charakterystykę jest pokazany na schemacie poniżej.

Kombinacja obu parametrów może wyglądać następująco:

Wobec tego nawet w przypadku wkładek MC, które miały zapewnić bardziej liniową charakterystykę, bo odpada problem niedopasowania pojemności, można napotkać trudności. Najczęściej podaje się przykład wkładki Denon DL 103 jako nie pasującej do standardowego wejścia przedwzmacniacza gramofonowego, które ma przeważnie 100 ohm, natomiast dla tej wkładki minimum to 470 ohm.

Jitter jest parametrem, który działa na audiofilów jak czerwona płachta na byka. Okazuje się, że odpowiednik jittera w analogu czyli kołysanie dźwięku jest o wiele rzędów wielkości większy i... nikomu to nie przeszkadza.

Ten wykres jest odpowiednikiem jitteru. Warto porównać jak wygląda ta sytuacja dla systemu cyfrowego w odniesieniu do przetworników i nietrudno zauważyć, że kołysanie w analogu jest nieporównywalnie silniejsze. Analizując wykres pokazujący równomierność obrotów gramofonu wykres trzeba mieć na uwadze, że wszystko co jest ponad -50 dB jest słyszalne. Natomiast w przeciwieństwie do odczytu mechanicznego jitter w systemie cyfrowym jest na poziomie gwarantującym całkowitą nieszkodliwość. Na wykresie jitteru mamy pośrodki tylko linię reprezentującą sygnał użyteczny, natomiast zakłócenia występują co najmniej 90 dB niżej. Wykres pokazujący kołysanie dźwięku w gramofonie analogowym właściwie w całości składa się z zakłóceń. Wszystko na tym wykresie to zakłócenia. Sygnał można zauważyć tylko i wyłącznie na samym szczycie tego jęzora i jest dosłownie zakryty zakłóceniami, które są one bardzo duże zaledwie 10 dB poniżej poziomu sygnału odniesienia.

Odczyt zapisu mechanicznego jest kłopotliwy. Systemowe wady płyty winylowej i wkładki gramofonowej, która często nie jest właściwie dopasowana do przedwzmacniacza to nie koniec problemów. Wkładkę gramofonu trzeba dopasować do przedwzmacniacza, albo na odwrót, ale wkładkę trzeba dopasować także do ramienia gramofonu.

Ramiona gramofonów charakteryzują się kilkoma parametrami, nie tylko długością. To czy ramię ma 9 czy 12 cali nie ma znaczenia. Ważna jest jego masa efektywna. Nie można użyć takiej samej wkładki do ramion 10 i 35 gramów.

Zupełnie osobne zagadnienie to regulacja wkładki i gramofonu. Paradoksalnie im większa precyzja ustawienia nacisku igły, tym większe problemy z jakością dźwięku. Okazuje się bowiem, że spora część użytkowników gramofonów kurczowo trzyma się dolnej granicy nacisku. Jeśli producent podaje tolerancję 2-2,5 grama, większość stara się ustawić 2 gramy. Tymczasem lepszym rozwiązaniem jest ustawienie 2,5 grama. Zdarza się natrafić na ripy płyt winylowych, które powinny brzmieć dobrze, bo sprzęt użyty do ich zrobienia był bardzo dobrej jakości, ale niestety zniekształcenia np. sybilantów są bardzo duże z powodu ustawienia za małego nacisku igły. Często też zdarza się złe ustawienie wkładki, przeważnie w środku zakresu regulacji, co nie zawsze się sprawdza. Znając typ gramofonu i wkładki można stwierdzić, że właściciel nie wykonał regulacji poprawnie.

W stosunku do zapisu cyfrowego i mechanicznego stosuje się dwa standardy oceny. Z jednej strony wyszukuje się i wyolbrzymia minimalne zniekształcenia w standardzie cyfrowym, a z drugiej stara się nie widzieć poważnych niedoskonałości zapisu mechanicznego. Mało kto wie, że sama płyta gramofonowa ma działanie mikrofonowe, które powoduje mniejsze lub większe zniekształcenia.

Chodzi o to, że dźwięk z głośników i w ogóle dźwięk z otoczenia powoduje drgania winylu, które są przetwarzane przez wkładkę. Efekt mikrofonowy jest dość silny i każdy może, a nawet powinien przekonać się, jak działa w praktyce.

Do testu efektu mikrofonowego potrzebny jest gramofon, który może nawet być uszkodzony i niekompletny. Gramofon musi mieć talerz z matą oraz ramię z wkładką. Napęd może być popsuty, igła może być złamana, wspornik igły wygięty. Liczy się to, że okablowanie jest sprawne.

Trzeba założyć płytę na talerz i opuścić ramię na płytę. Samego gramofonu nie trzeba poziomować itp. wystarczy go tylko podłączyć do wzmacniacza. Do wyjścia wzmacniacza, które można użyć do nagrywania, podłącza się komputer. W programie do nagrywania ustawić trzeba poziom nagrania odpowiedni do pozostałych źródeł dźwięku, a jeśli gramofon jest sprawny, można ustawić poziom nagrywania dla samego gramofonu.

Test polega na tym, że przełącza się wzmacniacz na gramofon, włącza nagrywanie w komputerze i po opuszczeniu ramienia na płytę, ale bez włączania obrotów - płyta nie może się kręcić - mówi się w stronę płyty zupełnie, jak do mikrofonu. Można mówić, śpiewać, deklamować.

Okazuje się, że na tak wykonanym nagraniu wyraźnie słychać słowa, słychać melodię itd. Zrozumiałość jest słaba, głośność mała, zupełnie jakby się słuchało przez ścianę, ale jednak, efekt mikrofonowania przez płytę jest wyraźny i dosyć silny. Jeśli się śpiewa lub mówi głośno, można zauważyć na wskaźnikach poziom dźwięku - 50 a nawet - 40 dB. Można również spróbować nagrać efekt przy odtwarzaniu głośnej muzyki. Taki test jednak jest bardziej skomplikowany, bo potrzebujemy zestawu, który będzie odtwarzał muzykę i przynajmniej dodatkowego wzmacniacza do którego podłączymy gramofon i z którego wyjścia będziemy mogli nagrywać.

Wobec tego okazuje się, że im głośniej się słucha, tym więcej zniekształceń mikrofonowych. W czasie słuchania muzyki są one raczej niemożliwe do zauważenia, chyba że gramofon sprzęga, jednak one są. Test z nagraniem efektu mikrofonowego wykazuje jednak dobitnie niedoskonałość zapisu mechanicznego. Warto podkreślić: bez trudu można spowodować zakłócenia na poziomie 40 dB poniżej sygnału użytecznego. Mikrofonowanie płyty jest dużo trudniejsze do wyłapania niż przesłuchy pomiędzy sąsiednimi rowkami.

Na koniec jeszcze raz wróćmy do "ciepłego dźwięku płyty winylowej". Jest on faktem i wynika przede wszystkim z niemożności zapisania na płycie góry pasma o normalnej głośności, a po części z rezonansów ramienia, korpusu gramofonu, efektu mikrofonowego itp. Jednak dla ogromnej większości użytkowników gramofonów w latach 70/80 ubiegłego wieku ten termin nie przyszedłby nigdy do głowy. Przede wszystkim polskie wkładki miały duże zniekształcenia, co potwierdzano pomiarami, miały kiepskie zawieszenie wspornika, co skutkowało rezonansem silniejszym niż w zachodnich produktach. Ale przede wszystkim te wkładki były typu MM i można stwierdzić, że problem podbicia wysokich tonów był powszechny. Płyty analogowe w tamtych czasach nie brzmiały ciepło.

Wynalezienie wkładki MC prawdopodobnie nie wynikało z potrzeby podniesienia jakości dźwięku, bo różnicy pomiędzy typem MM i MC raczej nie da się usłyszeć, ale właśnie dlatego, żeby uniknąć problemów z nieodpowiednią pojemnością kabla, przedwzmacniacza itp. Źle dopasowane pojemności i podbicie wysokich tonów skutkują dźwiękiem ostrym i twardym, który można określić na wszelkie sposoby, ale "ciepło" nie będzie oddawało charakteru dźwięku.

Największy problem z winylem polega na tym, że wszystkie wady i ograniczenia da się obejść przez przejście na system cyfrowy. Zamiast walczyć z kurzem, zużywaniem się płyty, szumem, trzaskami, stukami, zniekształceniami itd. można użyć odtwarzacza cyfrowego i wszystkie te problemy znikają, a jakość dźwięku znacznie się poprawia.

Mechaniczny zapis na płycie winylowej jest obarczony wieloma mankamentami, to samo dotyczy odczytu takich płyt. Jednak każdy przyzna, że winyl nie brzmi źle. Może z wyjątkiem ostatnich kilku minut zapisu na stronie. Ale to wynika z niedoskonałości słuchu. Gdybyśmy mieli trochę lepszy słuch, nikt nie chciałby używać płyt winylowych. Słyszymy jednak na tyle nieprecyzyjnie, że większości zniekształceń nie jesteśmy w stanie wychwycić.

Płyta winylowa jest nośnikiem trwałym wtedy, gdy nie jest odtwarzana, każdorazowe jej zagranie powoduje degradację zapisu. Najszybciej można zorientować się w skali zjawiska, jeśli igła zostanie opuszczona na czyste miejsce. Okaże się, że igła zostawi na płycie wgniecenie. Zamiast płyt można użyć płytki CD albo DVD. Po opuszczeniu igły na płytę obracamy powoli talerz gramofonu. Każdy ruch pozostawia na płycie ślad. Jeśli się użyje do regulacji siły dośrodkowej czystej płyty lub płytki CD/DVD okaże się, że powierzchnia płyty jest mocno porysowana. Płyty winylowe stwarzają problemy jeśli trzeba ich użyć do wykonania pomiarów, np. wkładki. Zapis po każdym odtworzeniu ulega starciu i dlatego w pewnym momencie pomiary nie są już miarodajne.

Na płycie winylowej można z pewnymi ograniczeniami zapisać pełne pasmo, ale trudność sprawia odczyt.

Jedyną szansą na niezniekształcony odczyt wysokich częstotliwości dla fragmentu płyty w pobliżu jej środka jest gramofon laserowy. Średnica promienia lasera śledzącego zapis jest znacznie mniejsza niż rozmiary igły gramofonowej. Typowa igła nie zmieści się w najgęstsze składniki zapisu. Poniższy rysunek przedstawia wielkość realnej igły i teoretyczną wymaganą. Jednak w praktyce nie jest możliwe wykonanie szlifu z tak małymi krzywiznami.

Jakość dźwięku jest tym gorsza im bliżej środka. Producenci przeciwdziałają temu w ten sposób, że dla końcowych minut zapisu modyfikują go zmniejszając ilość najwyższych częstotliwości. Kształtowanie dźwięku, żeby uniknąć zniekształceń jest powodem ukucia terminu "ciepły dźwięk analogu". Nie ma możliwości nacięcia matrycy z normalną ilością wysokich tonów. Powody są dwa. Przede wszystkim głowica nacinająca nie jest w stanie naciąć większej ilości wysokich tonów bez zniekształceń. Po drugie większa, czyli zwyczajna nawet dla nagrań wykonanych analogowo, ilość wysokich tonów spowoduje przegrzanie się i być może nawet spalenie głowicy.

Zbyt duża dynamika zapisu spowoduje przeciążenie samej wkładki gramofonowej, która może nie być w stanie śledzić dużych amplitud. Z kolei, jak to widać na rysunkach, większa amplituda wysokich tonów w granicach możliwości głowicy nacinającej będzie niemożliwa do śledzenia przez bardziej proste szlify igły. Igła sferyczna nie ma szans, igła eliptyczna nie zawsze będzie w stanie zmieścić się w gęstym zapisie, jedynie najbardziej zaawansowane kształty igły mogłyby sprostać zadaniu, ale i tak nie udałoby się poprawnie odczytać płyty naciętej 1:1 z typowego pliku. Odczytać górę pasma bez zniekształceń można, ale tylko wtedy, kiedy amplituda nie przekroczy pewnej wielkości, czyli zawsze trzeba ściszyć wysokie tony.

Paradoksalnie lepsza jakość zapisu na płytach nacinanych systemem DMM skutkuje gorszą jakością odtwarzania, bo głośniejszy i zawierający bardziej normalną ilość wysokich tonów dźwięk jest nie do odtworzenia przez tańsze wkładki ze sferycznym szlifem igły.

Dlatego, że mało kto używa referencyjnych wkładek, producenci nacinają płyty bardziej zachowawczo niż to by było konieczne dla najlepszych systemów. Ale nawet bezkompromisowo nacięta płyta nie jest w stanie dorównać dynamiką i jakością zapisowi cyfrowemu. Poza tym problemem są matryce z lakierem. Źle nacięte powodują przesłuchy pomiędzy sąsiadującymi rowkami, spada dynamika, wzrastają zniekształcenia. Za gorące ostrze - lakier będzie się topił i płynął. Za zimne - lakier będzie się ciągnął jak guma. W obu przypadkach wzrosną zniekształcenia i spadnie dynamika. Dlatego nacięcie płyty jest sztuką. I z całą pewnością nikt w Polsce nigdy nie naciął acetatu prawidłowo. Najczęstsza wada polskich płyt to preecho kiedy słychać dźwięk przebity z sąsiedniego rowka. Właśnie dlatego często utwory zaczynają się "dwa razy". Raz bardzo cicho, a potem zwyczajnie. Trzeba jednak mieć świadomość tego, że ten przesłuch dotyczy całej płyty. Słychać go zazwyczaj na początku, ale występuje cały czas. Sprawdzić: "Zdzisław Piernik – Tuba" Polskie Nagrania.

Mało kto zadaje sobie pytanie jakiego poziomu zakłóceń można się spodziewać po samej płycie. Jeśli płyta jest wykonana ze szczególną starannością, zakłócenia będą wyglądać następująco:

Na wykresie spektrum zakłóceń od płyty (razem z zakłóceniami z gramofonu, ale te są bardzo małe) jest zaznaczone kolorem czerwonym. Po uśrednieniu okazuje się, że dla 20 Hz odstęp od zakłóceń jest tylko 65 dB, dla 100 Hz 80 dB i dopiero powyżej 200 Hz zakłócenia spadają do -90 dB. Ale nie znaczy to, że odstęp od szumu dla płyty winylowej wynosi 90 dB. Taki odstęp od zakłóceń jest od 200 do 500 Hz. Winyl szumi dosyć głośno i nie sposób tego nie usłyszeć. Zakłócenia w zakresie niskich częstotliwości na płytach z muzyką są większe niż na płytach testowych. Starsze płyty mają dość bogate spektrum przeróżnych całkiem głośnych zakłóceń. Ważony odstęp od zakłóceń dla dobrego gramofonu to zaledwie 70 dB.

Jakim poziomem zniekształceń jest obarczony zapis na samej płycie? Nacinanie płyty odbywa się na granicy wytrzymałości termicznej głowicy. Towarzyszą temu również problemy mechaniczne, które powodują powstanie zniekształceń. Każdy, kto słuchał kiedykolwiek płyt winylowych wie, że dźwięk nie jest zupełnie czysty.

Głowica nacinająca jest sterowana wzmacniaczem o mocy kilkuset wat. Można przyjąć dla uproszczenia, że wzmacniacz ma 2x1000W - dwa kilowaty. Nie dziwi więc, że przy takich mocach uzwojenie głowicy może się przegrzać i spalić.

Dlaczego trzeba użyć takich mocy? Dlatego, że głowica ma pewną masę i może być tłumiona wyłącznie mechanicznie. Głośniki niskotonowe są tłumione zarówno mechanicznie, przez zawieszenie górne i dolne, ale też elektrycznie. Tłumienie elektryczne wiąże się z osławionym współczynnikiem tłumienia. W przypadku głowicy nacinającej nie jest możliwe tłumienie elektryczne z wielu względów. Jednak właśnie dlatego, że jest możliwe tłumienie tylko mechaniczne, głowica musi być zawieszona bardzo twardo. Tak twarde zawieszenie jest konieczne, bo zniekształcenia w przeciwnym razie będą zbyt duże. I przede wszystkim stąd biorą się tak duże moce wzmacniaczy. Warto się nad tym przez chwilę zastanowić: dwa kilowaty, żeby wychylenie wyniosło mniej niż milimetr. Kilowat na część milimetra w jednym kanale i kilowat na część milimetra w drugim.

Jeśli chodzi o wydania zagraniczne trzeba wprawnego ucha, żeby wychwycić zniekształcenia, bo specjaliści nacinający matryce świetnie orientują się w ograniczeniach i możliwościach sprzętu, więc mogą tak wpłynąć na dźwięk, żeby nie dopuścić do przeforsowania głowicy. Jak się to robi, to dość obszerny temat, głównie wpływa się na barwę obniżając ilość wysokich tonów i spłaszcza impulsy. Jednak w Polsce osoby nacinające płyty raczej nie miały wystarczającej wiedzy i umiejętności, a być może także nie miały do dyspozycji odpowiednich narzędzi. W każdym razie prawie zawsze można usłyszeć zniekształcenia na polskich wydawnictwach. Dowodzi to, że zapis na płycie ma duże ograniczenia i jeśli się nie podejmie odpowiednich kroków, wyjdą one na jaw w pełnej krasie.

W latach siedemdziesiątych, posługiwano się często sprzętem do nacinania matryc, który miał zniekształcenia rzędu jeden-dwa procenty, ale taki poziom zniekształceń może się utrzymać najwyżej do połowy strony, dalej będzie już znacznie gorzej, a finał opery na końcu strony - szkoda słów. I te zniekształcenia są na tych płytach. Nie zawsze je słyszymy, ale one są, a są trudne do uchwycenia, bo nie mamy możliwości porównania jak brzmi master.

Zobaczmy teraz jak się sprawy mają w odniesieniu do sprzętu odtwarzającego.

Jeśli chodzi o wkładki gramofonowe, to typowa charakterystyka częstotliwościowa wygląda w ten sposób:

Ale rezonans zawieszenia igły nie ma nic wspólnego z innym rezonansem.

Powyższy schemat pokazuje charakterystykę dla przedwzmacniacza MM. Podbicie wynika z nieodpowiednich parametrów przedwzmacniacza. Poniższy schemat jest w zasadzie obwodem rezonansowym. Od lewej: silnik wkładki, indukcyjność wkładki, opór wkładki, pojemność kabla, pojemność przedwzmacniacza i jego opór. Problem sprawiają zbyt duże C2 i R2

W skrajnych przypadkach podbicie wysokich tonów może sięgnąć nawet ponad 6 dB. Okazuje się jednak, że nie tylko wkładki MM nastręczają problemów. Również układy MC są podatne na zmiany parametrów obciążenia, przy czym głównie dotyczy to oporu. Jednak również pojemność może odgrywać pewną rolę, co widać na rysunku poniżej.

Kombinacja obu parametrów może wyglądać następująco:

Wobec tego nawet w przypadku wkładek MC, które miały zapewnić bardziej liniową charakterystykę, bo odpada problem niedopasowania pojemności, można napotkać trudności. Najczęściej podaje się przykład wkładki Denon DL 103 jako nie pasującej do standardowego wejścia przedwzmacniacza gramofonowego, które ma przeważnie 100 ohm, natomiast dla tej wkładki minimum to 470 ohm.

Jitter jest parametrem, który działa na audiofilów jak czerwona płachta na byka. Okazuje się, że odpowiednik jittera w analogu czyli kołysanie dźwięku jest o wiele rzędów wielkości większy i... nikomu to nie przeszkadza.

Ten wykres jest odpowiednikiem jitteru. Warto porównać jak wygląda ta sytuacja dla systemu cyfrowego w odniesieniu do przetworników i nietrudno zauważyć, że kołysanie w analogu jest nieporównywalnie silniejsze. Analizując wykres pokazujący równomierność obrotów gramofonu wykres trzeba mieć na uwadze, że wszystko co jest ponad -50 dB jest słyszalne. Natomiast w przeciwieństwie do odczytu mechanicznego jitter w systemie cyfrowym jest na poziomie gwarantującym całkowitą nieszkodliwość. Na wykresie jitteru mamy pośrodki tylko linię reprezentującą sygnał użyteczny, natomiast zakłócenia występują co najmniej 90 dB niżej. Wykres pokazujący kołysanie dźwięku w gramofonie analogowym właściwie w całości składa się z zakłóceń. Wszystko na tym wykresie to zakłócenia. Sygnał można zauważyć tylko i wyłącznie na samym szczycie tego jęzora i jest dosłownie zakryty zakłóceniami, które są one bardzo duże zaledwie 10 dB poniżej poziomu sygnału odniesienia.

Odczyt zapisu mechanicznego jest kłopotliwy. Systemowe wady płyty winylowej i wkładki gramofonowej, która często nie jest właściwie dopasowana do przedwzmacniacza to nie koniec problemów. Wkładkę gramofonu trzeba dopasować do przedwzmacniacza, albo na odwrót, ale wkładkę trzeba dopasować także do ramienia gramofonu.

Ramiona gramofonów charakteryzują się kilkoma parametrami, nie tylko długością. To czy ramię ma 9 czy 12 cali nie ma znaczenia. Ważna jest jego masa efektywna. Nie można użyć takiej samej wkładki do ramion 10 i 35 gramów.

Zupełnie osobne zagadnienie to regulacja wkładki i gramofonu. Paradoksalnie im większa precyzja ustawienia nacisku igły, tym większe problemy z jakością dźwięku. Okazuje się bowiem, że spora część użytkowników gramofonów kurczowo trzyma się dolnej granicy nacisku. Jeśli producent podaje tolerancję 2-2,5 grama, większość stara się ustawić 2 gramy. Tymczasem lepszym rozwiązaniem jest ustawienie 2,5 grama. Zdarza się natrafić na ripy płyt winylowych, które powinny brzmieć dobrze, bo sprzęt użyty do ich zrobienia był bardzo dobrej jakości, ale niestety zniekształcenia np. sybilantów są bardzo duże z powodu ustawienia za małego nacisku igły. Często też zdarza się złe ustawienie wkładki, przeważnie w środku zakresu regulacji, co nie zawsze się sprawdza. Znając typ gramofonu i wkładki można stwierdzić, że właściciel nie wykonał regulacji poprawnie.

W stosunku do zapisu cyfrowego i mechanicznego stosuje się dwa standardy oceny. Z jednej strony wyszukuje się i wyolbrzymia minimalne zniekształcenia w standardzie cyfrowym, a z drugiej stara się nie widzieć poważnych niedoskonałości zapisu mechanicznego. Mało kto wie, że sama płyta gramofonowa ma działanie mikrofonowe, które powoduje mniejsze lub większe zniekształcenia.

Chodzi o to, że dźwięk z głośników i w ogóle dźwięk z otoczenia powoduje drgania winylu, które są przetwarzane przez wkładkę. Efekt mikrofonowy jest dość silny i każdy może, a nawet powinien przekonać się, jak działa w praktyce.

Do testu efektu mikrofonowego potrzebny jest gramofon, który może nawet być uszkodzony i niekompletny. Gramofon musi mieć talerz z matą oraz ramię z wkładką. Napęd może być popsuty, igła może być złamana, wspornik igły wygięty. Liczy się to, że okablowanie jest sprawne.

Trzeba założyć płytę na talerz i opuścić ramię na płytę. Samego gramofonu nie trzeba poziomować itp. wystarczy go tylko podłączyć do wzmacniacza. Do wyjścia wzmacniacza, które można użyć do nagrywania, podłącza się komputer. W programie do nagrywania ustawić trzeba poziom nagrania odpowiedni do pozostałych źródeł dźwięku, a jeśli gramofon jest sprawny, można ustawić poziom nagrywania dla samego gramofonu.

Test polega na tym, że przełącza się wzmacniacz na gramofon, włącza nagrywanie w komputerze i po opuszczeniu ramienia na płytę, ale bez włączania obrotów - płyta nie może się kręcić - mówi się w stronę płyty zupełnie, jak do mikrofonu. Można mówić, śpiewać, deklamować.

Okazuje się, że na tak wykonanym nagraniu wyraźnie słychać słowa, słychać melodię itd. Zrozumiałość jest słaba, głośność mała, zupełnie jakby się słuchało przez ścianę, ale jednak, efekt mikrofonowania przez płytę jest wyraźny i dosyć silny. Jeśli się śpiewa lub mówi głośno, można zauważyć na wskaźnikach poziom dźwięku - 50 a nawet - 40 dB. Można również spróbować nagrać efekt przy odtwarzaniu głośnej muzyki. Taki test jednak jest bardziej skomplikowany, bo potrzebujemy zestawu, który będzie odtwarzał muzykę i przynajmniej dodatkowego wzmacniacza do którego podłączymy gramofon i z którego wyjścia będziemy mogli nagrywać.

Wobec tego okazuje się, że im głośniej się słucha, tym więcej zniekształceń mikrofonowych. W czasie słuchania muzyki są one raczej niemożliwe do zauważenia, chyba że gramofon sprzęga, jednak one są. Test z nagraniem efektu mikrofonowego wykazuje jednak dobitnie niedoskonałość zapisu mechanicznego. Warto podkreślić: bez trudu można spowodować zakłócenia na poziomie 40 dB poniżej sygnału użytecznego. Mikrofonowanie płyty jest dużo trudniejsze do wyłapania niż przesłuchy pomiędzy sąsiednimi rowkami.

Na koniec jeszcze raz wróćmy do "ciepłego dźwięku płyty winylowej". Jest on faktem i wynika przede wszystkim z niemożności zapisania na płycie góry pasma o normalnej głośności, a po części z rezonansów ramienia, korpusu gramofonu, efektu mikrofonowego itp. Jednak dla ogromnej większości użytkowników gramofonów w latach 70/80 ubiegłego wieku ten termin nie przyszedłby nigdy do głowy. Przede wszystkim polskie wkładki miały duże zniekształcenia, co potwierdzano pomiarami, miały kiepskie zawieszenie wspornika, co skutkowało rezonansem silniejszym niż w zachodnich produktach. Ale przede wszystkim te wkładki były typu MM i można stwierdzić, że problem podbicia wysokich tonów był powszechny. Płyty analogowe w tamtych czasach nie brzmiały ciepło.

Wynalezienie wkładki MC prawdopodobnie nie wynikało z potrzeby podniesienia jakości dźwięku, bo różnicy pomiędzy typem MM i MC raczej nie da się usłyszeć, ale właśnie dlatego, żeby uniknąć problemów z nieodpowiednią pojemnością kabla, przedwzmacniacza itp. Źle dopasowane pojemności i podbicie wysokich tonów skutkują dźwiękiem ostrym i twardym, który można określić na wszelkie sposoby, ale "ciepło" nie będzie oddawało charakteru dźwięku.

Największy problem z winylem polega na tym, że wszystkie wady i ograniczenia da się obejść przez przejście na system cyfrowy. Zamiast walczyć z kurzem, zużywaniem się płyty, szumem, trzaskami, stukami, zniekształceniami itd. można użyć odtwarzacza cyfrowego i wszystkie te problemy znikają, a jakość dźwięku znacznie się poprawia.

Mechaniczny zapis na płycie winylowej jest obarczony wieloma mankamentami, to samo dotyczy odczytu takich płyt. Jednak każdy przyzna, że winyl nie brzmi źle. Może z wyjątkiem ostatnich kilku minut zapisu na stronie. Ale to wynika z niedoskonałości słuchu. Gdybyśmy mieli trochę lepszy słuch, nikt nie chciałby używać płyt winylowych. Słyszymy jednak na tyle nieprecyzyjnie, że większości zniekształceń nie jesteśmy w stanie wychwycić.

sobota, 14 maja 2016

Odpowiedź impulsowa i skokowa głośników, przetwarzanie transientów

Dźwięki muzyki składają się z trzech elementów: ataku czyli transientu, fazy podtrzymania i wygasania. Szarpnięcie struny kostką może wyglądać tak:

Dźwięk może się więc składać głównie z ataku. Gra na skrzypcach z kolei zawiera długie fazy podtrzymania i krótkie wygasania, fortepian może mieć długie fazy wygasania.

Atak jest najsłabszą stroną głośników i dziwnym zbiegiem okoliczności nie podaje się zniekształceń dla tej fazy, ale dla podtrzymania.

Jest wiele powodów, że głośniki przetwarzają sygnały nieregularne i o dużej amplitudzie dość kiepsko. Masa wiąże się z bezwładnością. Dochodzi do tego niewystarczająca sztywność. Z kolei membrany bardzo sztywne bardziej rezonują. Głośnik napędza energia pola magnetycznego. Żeby uzmysłowić sobie o co chodzi najprościej wziąć do ręki dwa magnesy - pole magnetyczne jest elastyczne, nie jest sztywne. Więc napędzamy głośniki jakby popychając je przez coś, co się ugina i amortyzuje.

Zniekształcenia dla ataku są znacznie większe niż dla pomiarów sygnałami ciągłymi. Głośnik przetwarzając sygnał o charakterze powtarzających się cykli radzi sobie całkiem dobrze o ile nie będzie przeciążony. Jednak nawet głośnik przetwarzający sinusoidę zniekształca ją w odniesieniu do pierwszego okresu. Ruch membrany jest spóźniony, a amplituda mniejsza niż dla następnych cykli. Także gwałtowne urwanie się sinusoidy nie spowoduje, że ruch membrany natychmiast zaniknie.

Problem w tym, że muzyka składa się głównie z transientów. I dlatego głośniki brzmią nienaturalnie. Można się o tym przekonać mając do dyspozycji dobry mikrofon i zestaw wzmacniacz/głośniki. Głos osoby mówiącej do mikrofonu brzmi inaczej niż mówiącej bez mikrofonu. Jest wiele czynników powodujących zmianę brzmienia, ale jednym z ważniejszych jest złe przetwarzanie transientów przez głośniki.

Na szczęście dla większości słuchaczy nie znają oni dźwięku instrumentów grających na żywo, chodzi o instrumenty akustyczne. Również mało kto słyszał wokalistów śpiewających live bez mikrofonu. A zresztą gdyby nawet, to mało kto zwraca uwagę na naturalne brzmienie. Przetwarzanie dźwięku i zmiana jego parametrów nikomu jakby nie wadzi. Wystarczy przesłuchać kilka płyt, włączyć radio albo telewizor. W ogóle wydaje się, że większość preferuje brzmienie sztuczne i nienaturalne. Większość osób może niechętnie, ale przyzna, że koncert orkiestry symfonicznej bardziej im odpowiada, jeśli jest słuchany przez radio...

Czy to aby nie jest tak, że zmiana charakteru dźwięku spowodowana słabszym oddaniem ataku jest przez amatorów muzyki mechanicznej odbierana na korzyść? Czyli lepsze, bo gorsze, nienaturalne i sztuczne. Realizatorzy dźwięku nie stosowaliby tak silnej kompresji, gdyby to większości nie odpowiadało. Większość zdaje się być niestety niemuzykalna.

Atak jest najsłabszą stroną głośników i dziwnym zbiegiem okoliczności nie podaje się zniekształceń dla tej fazy, ale dla podtrzymania.

Jest wiele powodów, że głośniki przetwarzają sygnały nieregularne i o dużej amplitudzie dość kiepsko. Masa wiąże się z bezwładnością. Dochodzi do tego niewystarczająca sztywność. Z kolei membrany bardzo sztywne bardziej rezonują. Głośnik napędza energia pola magnetycznego. Żeby uzmysłowić sobie o co chodzi najprościej wziąć do ręki dwa magnesy - pole magnetyczne jest elastyczne, nie jest sztywne. Więc napędzamy głośniki jakby popychając je przez coś, co się ugina i amortyzuje.

Zniekształcenia dla ataku są znacznie większe niż dla pomiarów sygnałami ciągłymi. Głośnik przetwarzając sygnał o charakterze powtarzających się cykli radzi sobie całkiem dobrze o ile nie będzie przeciążony. Jednak nawet głośnik przetwarzający sinusoidę zniekształca ją w odniesieniu do pierwszego okresu. Ruch membrany jest spóźniony, a amplituda mniejsza niż dla następnych cykli. Także gwałtowne urwanie się sinusoidy nie spowoduje, że ruch membrany natychmiast zaniknie.

Problem w tym, że muzyka składa się głównie z transientów. I dlatego głośniki brzmią nienaturalnie. Można się o tym przekonać mając do dyspozycji dobry mikrofon i zestaw wzmacniacz/głośniki. Głos osoby mówiącej do mikrofonu brzmi inaczej niż mówiącej bez mikrofonu. Jest wiele czynników powodujących zmianę brzmienia, ale jednym z ważniejszych jest złe przetwarzanie transientów przez głośniki.

Na szczęście dla większości słuchaczy nie znają oni dźwięku instrumentów grających na żywo, chodzi o instrumenty akustyczne. Również mało kto słyszał wokalistów śpiewających live bez mikrofonu. A zresztą gdyby nawet, to mało kto zwraca uwagę na naturalne brzmienie. Przetwarzanie dźwięku i zmiana jego parametrów nikomu jakby nie wadzi. Wystarczy przesłuchać kilka płyt, włączyć radio albo telewizor. W ogóle wydaje się, że większość preferuje brzmienie sztuczne i nienaturalne. Większość osób może niechętnie, ale przyzna, że koncert orkiestry symfonicznej bardziej im odpowiada, jeśli jest słuchany przez radio...

Czy to aby nie jest tak, że zmiana charakteru dźwięku spowodowana słabszym oddaniem ataku jest przez amatorów muzyki mechanicznej odbierana na korzyść? Czyli lepsze, bo gorsze, nienaturalne i sztuczne. Realizatorzy dźwięku nie stosowaliby tak silnej kompresji, gdyby to większości nie odpowiadało. Większość zdaje się być niestety niemuzykalna.

Subskrybuj:

Posty (Atom)